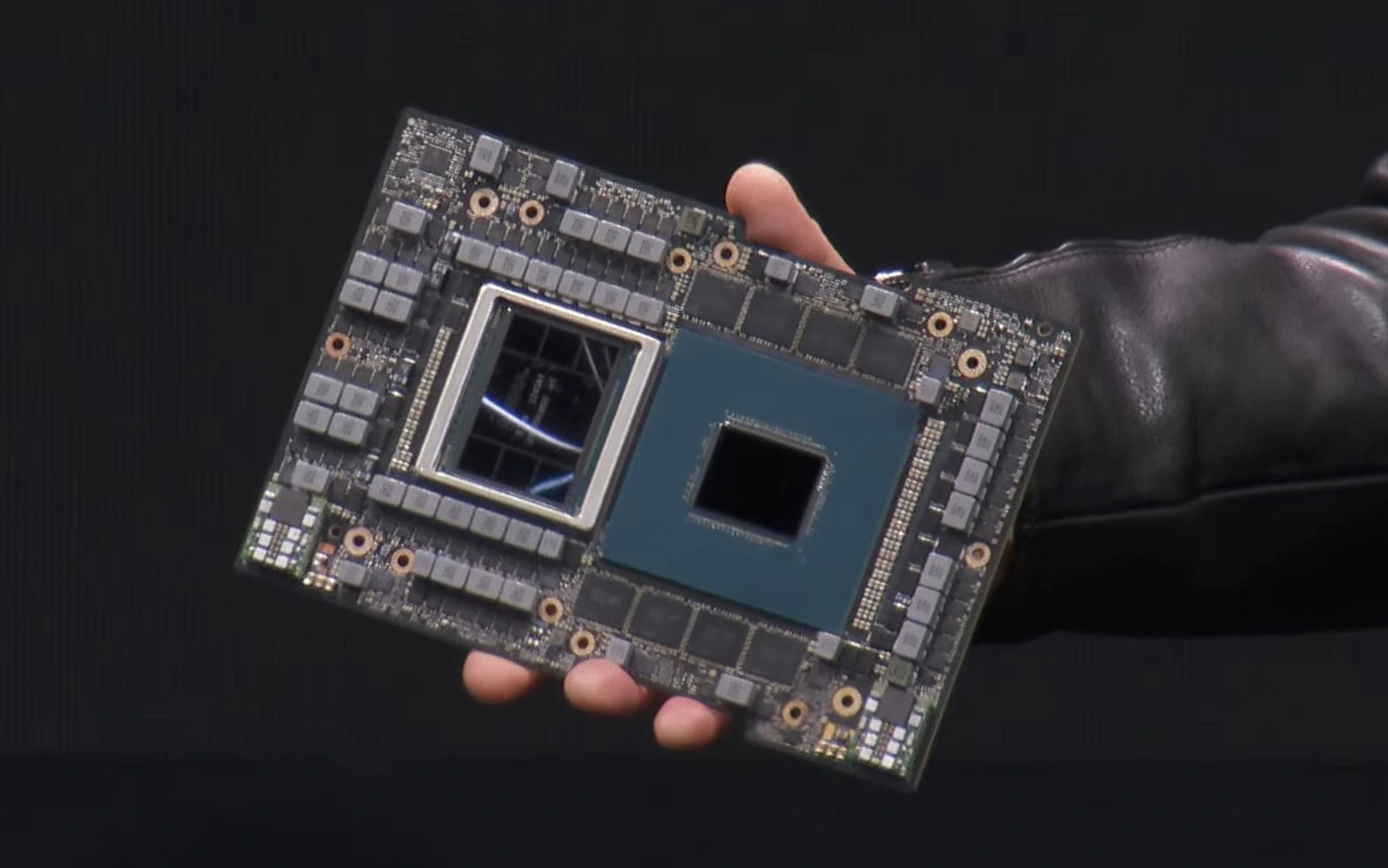

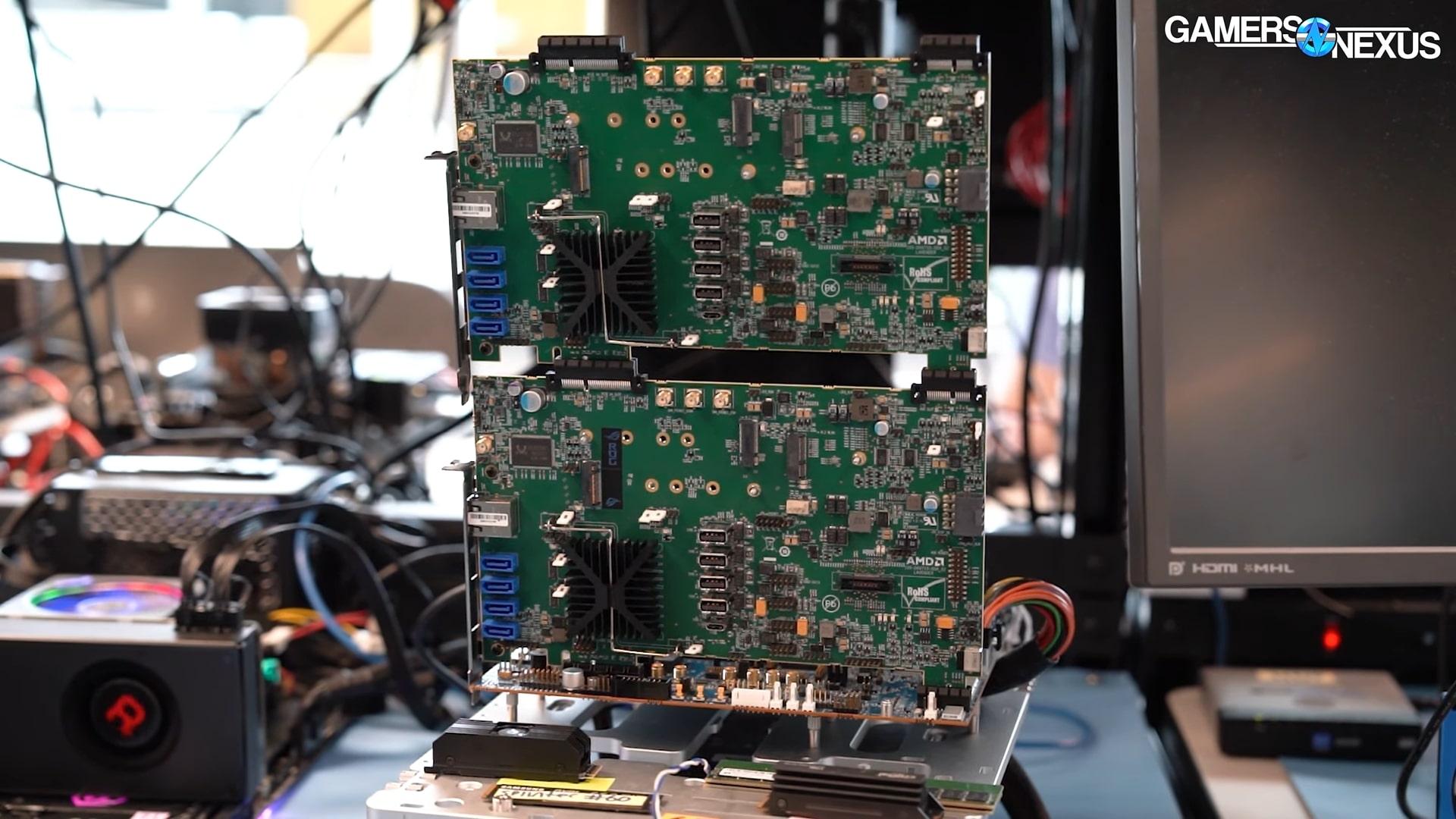

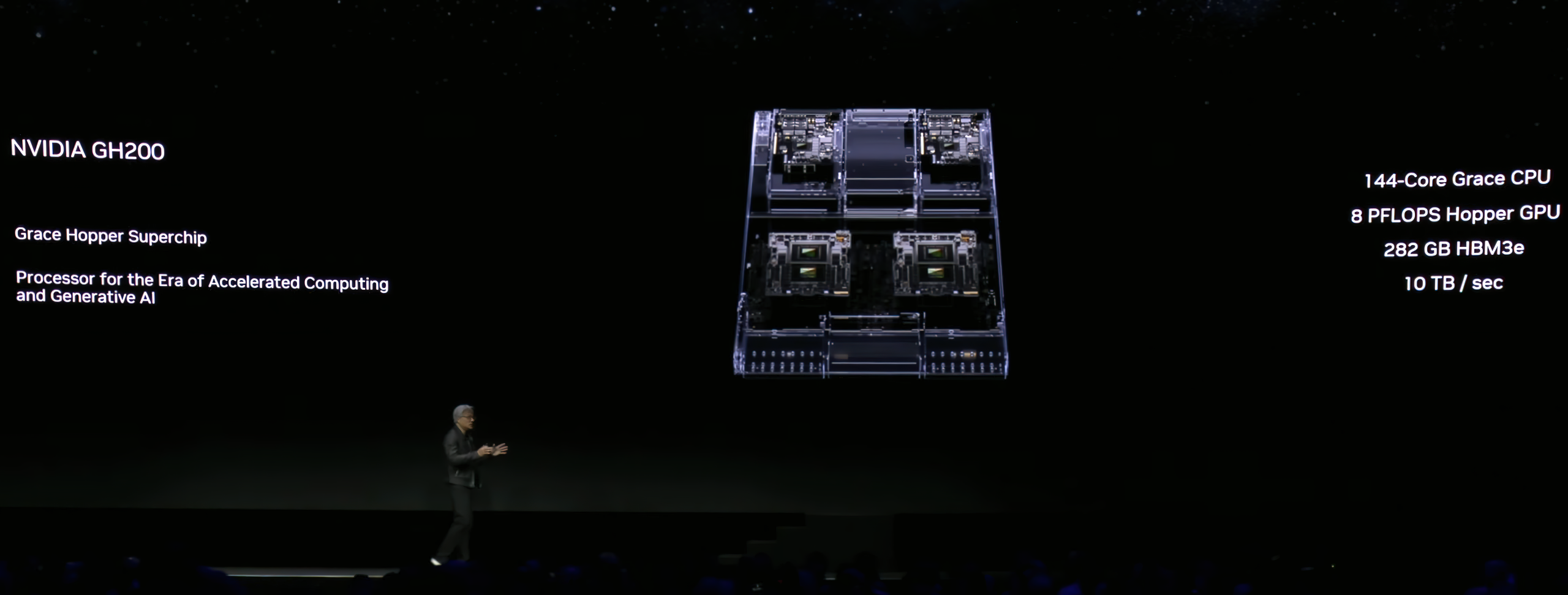

Mới đây, NVIDIA đã cho ra mắt siêu chip mới với sự cải tiến vượt trội với phân khúc máy chủ và siêu máy tính. Siêu chip này trang bị GPU kiến trúc Hopper, mang tên GH200, kết hợp giữa “siêu CPU” Grace (72 lõi Arm Neoverse mỗi chip), bộ nhớ LPDDR5X khủng nhất và GPU Hopper. Theo Nvidia, đây là siêu chip đầu tiên được trang bị bộ nhớ HBM3e 141GB công nghệ mới nhất, vừa tăng dung lượng vừa tăng cả băng thông bộ nhớ. Những hệ thống trang bị GPU GH200 giờ sẽ có tối đa 282GB bộ nhớ để vận hành xử lý và huấn luyện machine learning.

HBM3e có tốc độ nhanh hơn 50% so với HBM3 hiện tại, mỗi hệ thống siêu máy tính của Nvidia có thể đạt ngưỡng băng thông bộ nhớ 10TB/s, riêng lẻ từng GPU cũng đạt băng thông 5 GB/s. Trong tương lai, Nvidia dự kiến sẽ ứng dụng HBM3e cho những GPU phục vụ doanh nghiệp nói chung và AI nói riêng, từ CPU Grace, GPU Hopper, GPU Ada Lovelace và DPU (data processing unit) BlueField.

Tại sự kiện SIGGRAPH, Nvidia chỉ công bố một thông số duy nhất, sức mạnh 8 petaflops của Hopper GPU. Con số này, nếu là sức mạnh xử lý số thực dấu phẩy động FP8, thì sẽ cao gấp đôi GH100, được trang bị chip GPU xử lý AI mạnh nhất thế giới hiện tại, đạt sức mạnh xử lý FP16 lên tới 1979 teraflops, FP8 đạt 4000 teraflops.

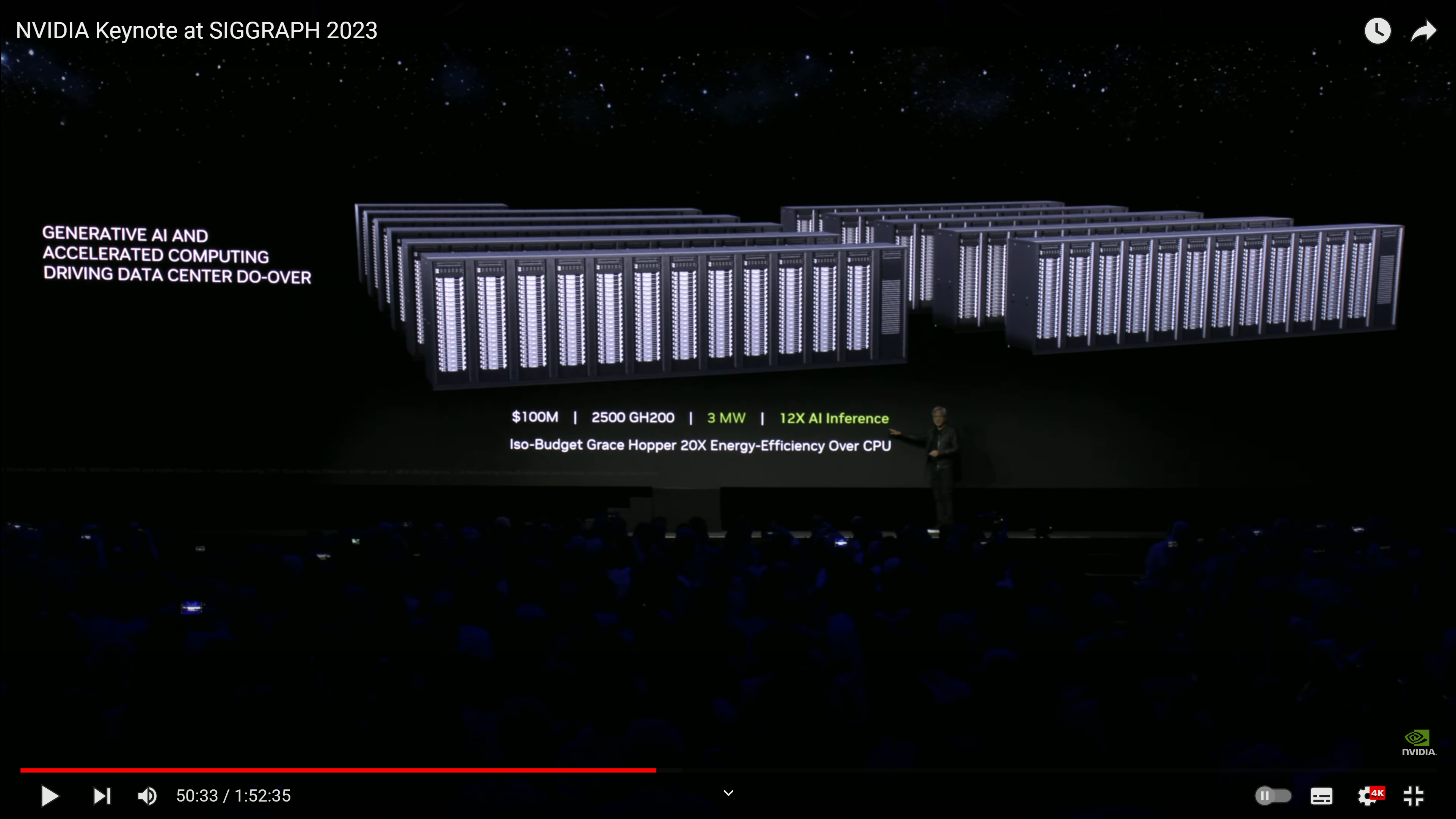

So với DGX A100, DGX GH200 mới ra mắt sử dụng hệ thống liên kết mới NVLink Switch System với 36 switch NVLink để liên kết 256 chip Grace Hopper – cho phép chúng hoạt động như một GPU khổng lồ có khả năng xử lý vượt trội – hiệu suất 1 EFLOPS, với bộ nhớ dùng chung 144TB, nhiều hơn 500 lần so với hệ thống DGX A100. Cuối cùng công ty còn công bố NVLink Switch mới và các nền tảng kết nối mạng Bluefield-3, ConnectX-7 và Quantum-2 InfiniBand mới, được thiết kế và tối ưu cho các máy chủ và các cụm siêu máy tính Superpod với nhau.

Đối với các tác vụ siêu nặng như huấn luyện hoặc xử lý các phép tính AI, khả năng liên kết các bộ xử lý với nhau thông qua các kết nối băng thông siêu lớn sẽ mang lại hiệu năng xử lý như một bộ xử lý duy nhất – lớn gấp nhiều lần so với một hệ thống siêu máy tính thông thường. Trước sự bùng nổ các công cụ AI sản sinh, khách hàng của Nvidia đang hối thúc công ty ra mắt các hệ thống có hiệu năng cao hơn nữa, thay vì chỉ giới hạn trong 8 GPU A100 như hiện tại và DGX GH200 HBM3e đã ra mắt nhằm đáp ứng yêu cầu như vậy.

Thông tin duy nhất mà Nvidia công bố là những hệ thống siêu máy tính và data center đầu tiên trang bị GPU GH200 sẽ được đưa vào vận hành kể từ quý II năm 2024, chậm hơn so với AMD Instinct MI300X 192GB RAM HBM3.