Trước Covid, Google đã phát hành mô hình MEENA, trong một thời gian ngắn, đây là mô hình ngôn ngữ lớn tốt nhất thế giới. Blog và bài viết mà Google viết cực kỳ dễ thương vì nó được so sánh cụ thể với OpenAI .

So với mô hình thế hệ tiên tiến hiện có, OpenAI GPT-2, Meena có công suất mô hình lớn hơn 1,7 lần và được đào tạo trên nhiều dữ liệu hơn 8,5 lần.

Mô hình này yêu cầu FLOPS của GPT-2 cao hơn 14 lần để huấn luyện, nhưng điều này phần lớn không liên quan vì chỉ vài tháng sau, OpenAI đã loại bỏ GPT-3, có nhiều tham số hơn >65 lần và số lượng mã thông báo >60 lần, FLOPS nhiều hơn >4.000 lần . Sự khác biệt về hiệu suất giữa hai mô hình này là rất lớn.

Mô hình MEENA đã khơi dậy một bản ghi nhớ nội bộ do Noam Shazeer viết có tựa đề “MEENA Eats The World”. Trong bản ghi nhớ này, anh ấy đã dự đoán nhiều điều mà phần còn lại của thế giới nhận ra sau khi ChatGPT phát hành. Điểm mấu chốt là các mô hình ngôn ngữ sẽ ngày càng hòa nhập vào cuộc sống của chúng ta theo nhiều cách khác nhau và chúng sẽ thống trị FLOPS được triển khai trên toàn cầu. Noam đã đi trước thời đại rất nhiều khi viết bài này, nhưng nó hầu như bị những người ra quyết định chủ chốt phớt lờ hoặc thậm chí cười nhạo.

Chúng ta hãy tiếp tục tìm hiểu xem Noam thực sự đã đi trước thời đại bao xa. Anh ấy là thành viên của nhóm đã thực hiện bài báo gốc về Transformer, “ Tất cả những gì bạn cần là sự chú ý ”. Ông cũng là thành viên của bài báo Mixture of Experts hiện đại đầu tiên , Switch Transformer , Image Transformer , và các phần tử khác nhau của LaMDA và PaLM . Một trong những ý tưởng từ năm 2018 mà anh ấy vẫn chưa được công nhận rộng rãi hơn là giải mã suy đoán mà chúng tôi đã trình bày chi tiết ở đây trong phần giới thiệu độc quyền của chúng tôi về GPT-4 . Giải mã suy đoán làm giảm chi phí suy luận gấp nhiều lần.

Vấn đề ở đây là Google có tất cả chìa khóa của vương quốc, nhưng họ đã đánh mất chiếc túi. Một tuyên bố rõ ràng đối với tất cả mọi người.

Tuyên bố có thể không rõ ràng là gã khổng lồ đang ngủ quên, Google đã thức dậy và họ đang lặp lại với tốc độ sẽ phá vỡ tổng FLOPS trước đào tạo GPT-4 lên gấp 5 lần trước cuối năm nay. Con đường rõ ràng là tăng gấp 20 lần vào cuối năm tới nhờ việc xây dựng cơ sở hạ tầng hiện tại của họ. Liệu Google có đủ can đảm để đưa những mô hình này ra công chúng mà không làm mất đi tính sáng tạo hay mô hình kinh doanh hiện tại của họ hay không lại là một cuộc thảo luận khác.

Hôm nay, chúng tôi muốn thảo luận về hệ thống đào tạo của Google dành cho Gemini, tốc độ lặp lại cho các mô hình Gemini, đoạn đường nối Viperfish (TPUv5) của Google, khả năng cạnh tranh của Google trong tương lai so với các phòng thí nghiệm hàng đầu khác và nhóm mà chúng tôi gọi là “Những người nghèo GPU“.

Những gã Big-tech giàu có với quá nhiều GPU

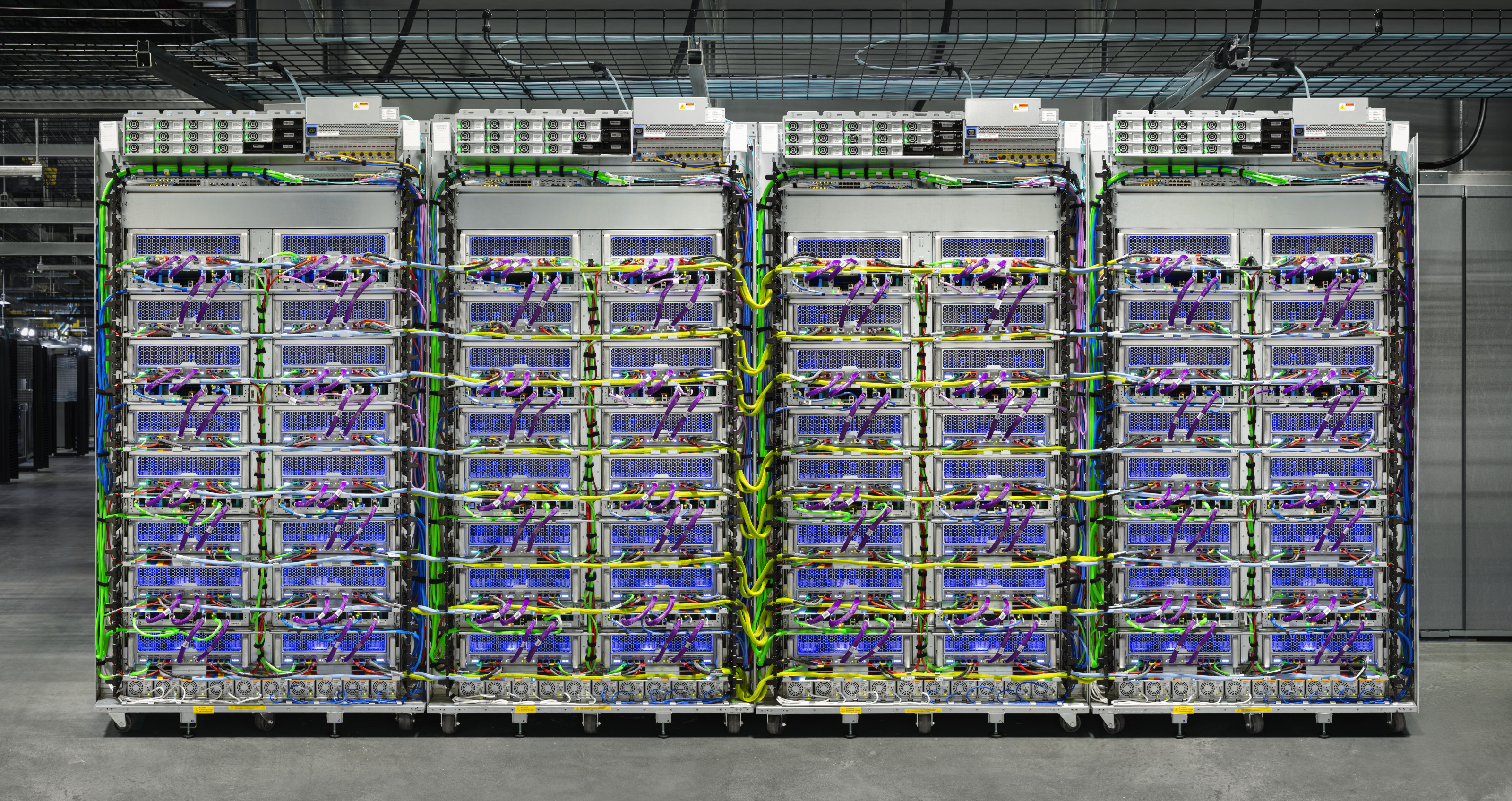

Quyền truy cập vào điện toán là một sự phân phối lưỡng kim. Có một số công ty có GPU A/H100 trên 20 nghìn và các nhà nghiên cứu riêng lẻ có thể truy cập 100 hoặc 1.000 GPU cho các dự án thú cưng. Đứng đầu trong số này là các nhà nghiên cứu tại OpenAI, Google, Anthropic, Inflection, X và Meta, những người sẽ có tỷ lệ tài nguyên máy tính cao nhất cho các nhà nghiên cứu. Một số công ty ở trên cũng như nhiều công ty Trung Quốc sẽ đạt hơn 100 nghìn vào cuối năm tới, mặc dù chúng tôi không chắc chắn về tỷ lệ các nhà nghiên cứu ở Trung Quốc, chỉ có số lượng GPU.

Một trong những xu hướng thú vị nhất mà chúng tôi thấy ở Vùng Vịnh là việc các nhà nghiên cứu ML hàng đầu khoe khoang về số lượng GPU mà họ có hoặc sẽ sớm có quyền truy cập. Trên thực tế, điều này đã trở nên phổ biến trong ~4 tháng qua đến mức nó trở thành một cuộc thi đo lường ảnh hưởng trực tiếp đến quyết định của các nhà nghiên cứu hàng đầu. Meta, người sẽ có số lượng GPU H100 nhiều thứ 2 trên thế giới, đang tích cực sử dụng nó như một chiến thuật tuyển dụng.

Những người nghèo GPU

Sau đó, có rất nhiều công ty khởi nghiệp và nhà nghiên cứu nguồn mở đang phải vật lộn với số lượng GPU ít hơn nhiều. Họ đang dành thời gian và nỗ lực đáng kể để cố gắng làm những việc mà đơn giản là không giúp ích gì, hoặc nói thẳng ra là quan trọng. Ví dụ: nhiều nhà nghiên cứu đang dành vô số thời gian để tinh chỉnh các mô hình có GPU không có đủ VRAM. Đây là cách sử dụng cực kỳ phản tác dụng đối với kỹ năng và thời gian của họ.

Các công ty khởi nghiệp và nhà nghiên cứu nguồn mở này đang sử dụng LLM lớn hơn để tinh chỉnh các mô hình nhỏ hơn cho các tiêu chuẩn về phong cách bảng xếp hạng với các phương pháp đánh giá bị hỏng nhằm nhấn mạnh hơn vào phong cách hơn là tính chính xác hoặc hữu ích. Nhìn chung, họ không biết rằng các tập dữ liệu huấn luyện trước và dữ liệu IFT cần phải lớn hơn/chất lượng cao hơn đáng kể để các mô hình mở nhỏ hơn cải thiện khối lượng công việc thực tế.

Đúng, việc sử dụng GPU hiệu quả là rất quan trọng, nhưng theo nhiều cách, điều đó đang bị những người kém GPU bỏ qua. Họ không quan tâm đến hiệu quả trên quy mô lớn và thời gian của họ không được sử dụng một cách hiệu quả. Những gì có thể được thực hiện về mặt thương mại trong môi trường thiếu GPU của họ hầu như không liên quan đến một thế giới sẽ tràn ngập hơn 3,5 triệu chiếc H100 vào cuối năm tới . Đối với việc học tập, thử nghiệm, GPU chơi game nhỏ hơn, yếu hơn là phù hợp.

Những người nghèo GPU vẫn chủ yếu sử dụng các mô hình dày đặc vì đó là thứ mà Meta đã ân cần đặt vào lòng họ với loạt mô hình LLAMA. Nếu không có ân huệ của God’s Zuck, hầu hết các dự án nguồn mở thậm chí còn trở nên tồi tệ hơn. Nếu họ thực sự quan tâm đến hiệu quả, đặc biệt là về phía khách hàng, thì họ sẽ chạy các kiến trúc mô hình thưa thớt như MoE, đào tạo về các bộ dữ liệu lớn hơn này và triển khai giải mã suy đoán như Frontier LLM Labs (OpenAI, Anthropic, Google Deepmind).

Những kẻ yếu hơn nên tập trung vào sự cân bằng để cải thiện hiệu suất mô hình hoặc độ trễ từ mã thông báo đến mã thông báo bằng cách nâng cao các yêu cầu về dung lượng bộ nhớ và tính toán theo hướng giảm băng thông bộ nhớ vì đó là những gì lợi thế cần. Họ nên tập trung vào việc phục vụ hiệu quả nhiều mô hình đã được tinh chỉnh trên cơ sở hạ tầng dùng chung mà không phải trả những khoản phạt chi phí khủng khiếp đối với quy mô lô nhỏ. Thay vào đó, họ liên tục tập trung vào những hạn chế về dung lượng bộ nhớ hoặc lượng tử hóa quá xa trong khi che mắt về việc giảm chất lượng thực.

Nói chung, để đi theo một hướng hơi tiếp tuyến, việc đánh giá mô hình bị hỏng. Trong khi có rất nhiều nỗ lực trong thế giới đóng để cải thiện điều này, thì mảnh đất của các tiêu chuẩn mở là vô nghĩa và các thước đo hầu như không hữu ích. Vì lý do nào đó, người ta có một nỗi ám ảnh không lành mạnh về việc xếp hạng các LLM trên bảng xếp hạng và đặt những cái tên ngớ ngẩn cho những người mẫu vô dụng (WizardVicunaUncensoredXPlusPlatypus). Hy vọng rằng các nỗ lực mở sẽ được chuyển hướng tới việc đánh giá, giải mã đầu cơ, MoE, dữ liệu IFT mở và làm sạch các bộ dữ liệu đào tạo trước với hơn 10 nghìn tỷ mã thông báo, nếu không, sẽ không có cách nào để nguồn mở cạnh tranh với những gã khổng lồ thương mại.

Trong khi Mỹ và Trung Quốc có thể tiếp tục chạy đua về phía trước, thì các công ty khởi nghiệp ở châu Âu và các siêu máy tính được chính phủ hỗ trợ như Jules Verne cũng hoàn toàn không có khả năng cạnh tranh. Châu Âu sẽ tụt lại phía sau trong cuộc đua này do không có khả năng đầu tư lớn và chọn cách tiếp tục ở mức nghèo GPU. Thậm chí nhiều quốc gia Trung Đông đang đầu tư nhiều hơn vào việc tạo điều kiện cho cơ sở hạ tầng quy mô lớn cho AI.

Tuy nhiên, việc có GPU kém không chỉ giới hạn ở những công ty khởi nghiệp yếu kém. Một số công ty AI được công nhận rộng rãi nhất là HuggingFace, Databricks (MosaicML) và Together cũng nằm trong nhóm có ít GPU này. Trên thực tế, họ có thể là nhóm có ít GPU nhất hiện nay xét về cả số lượng nhà nghiên cứu đẳng cấp thế giới trên mỗi GPU và số lượng GPU so với tham vọng/nhu cầu tiềm năng của khách hàng. Họ có những nhà nghiên cứu đẳng cấp thế giới, nhưng tất cả họ đều bị hạn chế khi làm việc trên các hệ thống có năng lực kém hơn. Các công ty này có nguồn đầu vào rất lớn từ các doanh nghiệp đào tạo người mẫu thực và theo đơn đặt hàng của hàng nghìn chiếc H100 sắp ra mắt, nhưng điều đó sẽ không đủ để chiếm lĩnh phần lớn thị trường.

Nvidia đang ăn trưa với số lượng GPU nhiều gấp nhiều lần trong dịch vụ DGX Cloud và nhiều siêu máy tính nội bộ khác nhau của họ. Đám mây DGX của Nvidia cung cấp các mô hình, khung xử lý dữ liệu, cơ sở dữ liệu vectơ và cá nhân hóa được đào tạo trước, công cụ suy luận được tối ưu hóa, API và sự hỗ trợ từ các chuyên gia NVIDIA để giúp doanh nghiệp điều chỉnh mô hình cho các trường hợp sử dụng tùy chỉnh của họ. Dịch vụ đó cũng đã thu hút nhiều doanh nghiệp lớn hơn từ các ngành dọc như SaaS, bảo hiểm, sản xuất, dược phẩm, phần mềm năng suất và ô tô. Mặc dù không phải tất cả khách hàng đều được công bố, ngay cả danh sách công khai của Amgen, Adobe, CCC, ServiceNow, Accenture, AstraZeneca, Getty Images, Shutterstock, Morningstar, Evozyne, Insilico Medicine, Quantiphi, InstaDeep, Oxford Nanopore, Peptone, Relation Therapeutics, ALCHEMAB Therapeutics và Runway khá ấn tượng.

Đây là một danh sách dài hơn nhiều so với những người chơi khác và Nvidia cũng có nhiều mối quan hệ đối tác chưa được tiết lộ khác. Nói rõ hơn, doanh thu từ những khách hàng đã công bố này của dịch vụ đám mây DGX của Nvidia vẫn chưa được xác định, nhưng với quy mô chi tiêu cho đám mây và việc xây dựng siêu máy tính nội bộ của Nvidia, có vẻ như nhiều dịch vụ có thể/sẽ được mua từ Đám mây của Nvidia hơn là HuggingFace, Together, và Databricks có thể hy vọng mang lại sự kết hợp.

Vài trăm triệu mà HuggingFace và Together đã quyên góp được có nghĩa là họ sẽ vẫn có GPU kém, bị bỏ rơi vì không thể đào tạo N-1 LLM có thể đóng vai trò là cơ sở để tinh chỉnh cho khách hàng. Điều này có nghĩa là cuối cùng họ sẽ không thể chiếm được thị phần cao ở những doanh nghiệp chỉ có thể truy cập dịch vụ của Nvidia ngày nay.

HuggingFace nói riêng có một trong những tên tuổi lớn nhất trong ngành và họ cần tận dụng điều đó để đầu tư một số tiền khổng lồ và xây dựng nhiều khả năng mô hình, tùy chỉnh và suy luận hơn. Vòng gần đây của họ được thực hiện với mức định giá quá cao để thu được khoản đầu tư cần thiết để cạnh tranh. Bảng xếp hạng của HuggingFace cho thấy họ thực sự mù quáng đến mức nào vì họ tích cực làm tổn hại đến phong trào nguồn mở bằng cách lừa nó tạo ra một loạt mô hình vô dụng cho việc sử dụng thực tế.

Databricks (MosaicML) ít nhất có thể bắt kịp do dữ liệu và kết nối doanh nghiệp của họ. Vấn đề là họ cần tăng tốc chi tiêu lên gấp nhiều lần nếu muốn có hy vọng phục vụ hơn 7.000 khách hàng của mình. Việc mua lại KhảmML trị giá 1,3 tỷ USD là một vụ đặt cược lớn cho ngành dọc này, nhưng họ cũng cần phải đầu tư một số tiền tương tự vào cơ sở hạ tầng. Thật không may cho Databricks, họ không thể trả tiền mua GPU bằng cổ phiếu. Họ cần thực hiện một đợt chào bán lớn thông qua vòng IPO/vòng IPO riêng tư sắp tới của mình và sử dụng số tiền mặt cứng rắn đó để tăng gấp bốn lần số lượng phần cứng.

Lập luận kinh tế thất bại vì họ phải xây dựng trước khi khách hàng có thể đến, vì Nvidia đang ném tiền vào dịch vụ của họ. Nói rõ hơn, nhiều người mua rất nhiều máy tính mà không thu lại được tiền (Cohere, Ả Rập Saudi, UAE), nhưng đó là điều kiện tiên quyết để cạnh tranh.

Các công ty đào tạo cuốc và xẻng và hoạt động suy luận (Databricks, HuggingFace và Together) đứng đằng sau đối thủ cạnh tranh chính của họ, đồng thời cũng là nguồn cung cấp hầu hết tất cả các tính toán của họ. Toán tử lớn nhất tiếp theo của các mô hình tùy chỉnh chỉ đơn giản là các API tinh chỉnh từ OpenAI.

Chìa khóa ở đây là tất cả mọi người từ Meta, Microsoft cho đến các công ty khởi nghiệp chỉ đơn giản đóng vai trò là nguồn cung cấp vốn cho tài khoản ngân hàng của Nvidia.

Có ai có thể cứu chúng ta khỏi chế độ nô lệ của Nvidia không?

Vâng, có một vị cứu tinh tiềm năng.

Google – Công ty giàu máy tính nhất thế giới

Mặc dù Google sử dụng GPU nội bộ cũng như một số lượng đáng kể được bán thông qua GCP, nhưng họ vẫn có sẵn một số Ace. Chúng bao gồm Gemini và lần lặp tiếp theo đã bắt đầu đào tạo. Lợi thế quan trọng nhất mà họ có là cơ sở hạ tầng hiệu quả vượt trội.

Trước khi đề cập đến Gemini và hoạt động kinh doanh trên nền tảng đám mây của họ, chúng tôi sẽ chia sẻ một số điểm dữ liệu về quá trình xây dựng điên rồ của họ. Biểu đồ bên dưới hiển thị tổng số chip nâng cao được thêm vào theo quý. Ở đây chúng tôi mang đến cho OpenAI mọi lợi ích đáng nghi ngờ. Rằng tổng số GPU họ có sẽ tăng gấp 4 lần trong vòng 2 năm. Đối với Google, chúng tôi bỏ qua toàn bộ nhóm TPUv4 (Pufferfish), TPUv4 lite và GPU được sử dụng nội bộ hiện có của họ. Hơn nữa, chúng tôi cũng không bao gồm TPUv5e (lite), mặc dù đó có thể là công cụ phù hợp để suy luận các mô hình ngôn ngữ nhỏ hơn. Sự tăng trưởng của Google trong biểu đồ này chỉ là TPUv5 (Viperfish).